von Rebekka Reichert

Drei Tage lang diskutieren, ausprobieren und vernetzen: Beim zweiten #SODaBarcamp25 kamen rund 40 Teilnehmer*innen aus 19 Städten und Institutionen an der Friedrich-Alexander-Universität in Erlangen-Nürnberg zusammen. Direkt bei der Ankunft wurden alle herzlich empfangen – nicht nur von den Gastgeber*innen, sondern auch von einem fantastischen vegetarischen Catering, das in den nun folgenden Tagen keinen Wunsch offen lassen sollte: Von frisch gebackenen Butterbrezeln bis hin zu würzigem veganem Chili.

Wie schon im vergangenen Jahr lebte das Barcamp von der Energie und den Ideen der Community: Über 30 Themenvorschläge wurden eingereicht, 20 davon fanden nach einer kurzen Abstimmung ihren Platz im Sessionplan. Mit vier parallelen Workshops pro Block fiel die Wahl oft schwer – am liebsten wäre man überall gleichzeitig gewesen.

Tag 1: Digitalisieren, suchen, sichtbar machen

Gleich in einer der ersten Sessions des Barcamps ging es mit einer visuellen Reise durch die Welt der Sammlungsdigitalisierung los: Anna Gnyp visualisierte auf einem Miroboard eine übersichtliche „Landkarte der Sammlungsdigitalisierung“. Die Karte deckt die Bereiche von der digitalen Erschließung über die Objektdigitalisierung bis hin zur Publikation und Archivierung von Sammlungsdaten ab.

Innerhalb der einzelnen Bereiche beinhaltet die Landkarte Informationen zu verschiedenen Anwendungen, Methoden, Software, Standards und Plattformen. In der Diskussion ergänzten die Teilnehmer*innen, welche Informationen auf der Karte noch fehlen und berieten, wie man die Karte nachnutzbar machen könnte.

Parallel dazu gab Martin Stricker spannende Einblicke in die Auswertung von Suchanfragen im Portal der Koordinierungsstelle für wissenschaftliche Universitätssammlungen.

Anhand praktischer Beispiele zeigte er typische Stolpersteine bei der Suche in verschiedenen Datenbanken – z.B. wie problematisch es ist, wenn diese keine automatische Korrektur von Rechtschreibfehlern vornehmen.

Weitere Herausforderungen betrafen unstrukturierte Suchbegriffe und die unterschiedlichen Erwartungen von Laien und Expert*innen. Gemeinsam wurde diskutiert, wie Sammlungsdaten besser auffindbar und sichtbar gemacht werden können – etwa durch den Einsatz von Elastic Search, strukturierten Filterfeldern, den Export von Daten in die Deutsche Digitale Bibliothek (DDB) oder eine gezielte Präsenz auf verschiedenen Wikimedia-Plattformen.

Tag 2: Ontologien, Knowledge Graphs und digitale Resilienz

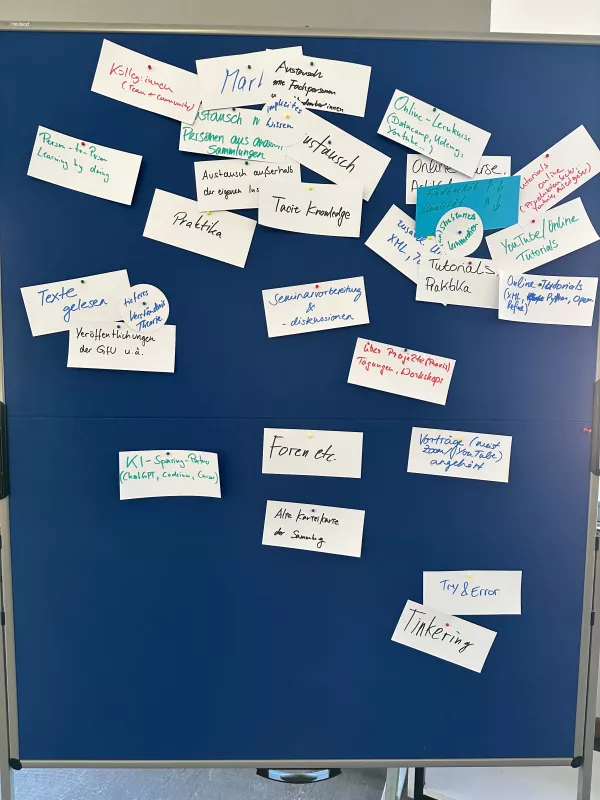

Wie kann man implizites Sammlungswissen weitergeben? Diese Frage stand im Mittelpunkt eines erkenntnisreichen Workshops von Jacqueline Klusik-Eckert (HU Düsseldorf, HeiCAD). Anhand ihrer zweiteiligen Open Educational Resource (OER) „KI für alle“ auf dem KI-Campus: https://ki-campus.org/node/995 zeigte sie praxisnah ihre Herangehensweise. Mit der Methode „Think–Pair–Share“ lud sie Teilnehmer*innen ein, erste Schritte in eine solche Kurskonzeption zu wagen. Gemeinsam wurden typische Bedarfe gesammelt – von Bildrechten bis hin zu Forschungsdatenmanagement – und verschiedenen Kompetenzstufen zugeordnet.

Daraus entwickelten sich kreative Ideen für praxisnahe Lernformate: Cheat Sheets, E-Learning-Kurse und Workshops, die helfen, Wissen nicht nur zu bewahren, sondern auch lebendig weiterzugeben.

Zeitgleich gab Gabriele Zöllner (SODa) spannende Einblicke in den Leitfaden für Standardisierungen bei Provenienzangaben. Anhand von drei Good-Practice-Beispielen wurde diskutiert, wie Sammlungen im Frontend ausführliche Provenienzinformationen übersichtlich präsentieren können. Ergänzend ging es um Standards für das Backend, wie klar definierte Metadatenfelder, Hilfetexte per Mouse-Over und die Kennzeichnung unsicherer Angaben. Auch Themen wie Bearbeitungsstatus, Versionierung und der sensible Umgang mit kritischen Provenienzen und Restitutionen sorgten für lebhafte Debatten.

In einer weiteren Session berichtete Else Schlegel (TU Dresden) über Erfahrungen mit der Deutschen Digitalen Bibliothek (DDB) und Europeana. Gemeinsam wurde diskutiert, wie Sammlungen trotz technischer Hürden und begrenzter Ressourcen besser sichtbar gemacht werden können. Eine kompakte SWOT-Analyse offenbarte Stärken wie überregionale Sichtbarkeit, aber auch Schwächen wie aufwendige Prozesse und begrenzte Reichweite.

Parallel dazu führte Gudrun Schwenk (SODa) in die Welt der Ontologien ein und stellte CIDOC CRM als internationalen Standard zur semantischen Modellierung von Kulturerbeinformationen vor. Aufgrund seiner ereignisbasierten und -zentrierten Struktur eignet sich CIDOC CRM besonders gut, um zeitlich begrenzte Ereignisse wie Konservierungsprozesse präzise zu beschreiben. Konservatorische Maßnahmen sind in ihrer Vielfalt oft schwer vergleichbar – die abstrakten Konzepte des Modells ermöglichen dennoch eine anschlussfähige Darstellung für spezifische Inhalte und Anforderungen.

Mehrere Teilnehmer*innen unterschiedlicher Disziplinen gaben Einblick in ihre laufenden Projekte zur Entwicklung von Ontologien. Dabei zeigte sich: Die Herangehensweise ist oft ähnlich – auf eine Umfeldanalyse folgt der schrittweise Aufbau einer semantischen Struktur. Klar wurde: Die Arbeit mit Ontologien ist ein offener, iterativer Prozess. Viele Projekte setzten auf ein reduziertes, generisches Kernschema, das bei Bedarf disziplinspezifisch erweitert wird. Kristina Fischer, die in einer eigenen Sitzung bereits Einblicke in ihre Arbeit mit kontrollierten Vokabularen, SKOS und der Entwicklung eines Thesaurus für Konservierung und Restaurierung gegeben hatte, stellte die Ergebnisse ihrer Umfeldanalyse in Form einer „Landkarte bestehender Ontologien“ auf einem Miro-Board vor.

Zum Abschluss des zweiten Tages stellte Nadine Raddatz (ZI) das Projekt kunst.bild.daten des Zentralinstituts für Kunstgeschichte München (ZI) vor. Am Beispiel der Fotosammlung wurde diskutiert, wie sich unterschiedliche Ebenen eines digitalisierten Sammlungsobjekts – vom Bildinhalt über die Aufnahme und das physische Fotoobjekt bis zum Digitalisat – klar erfassen und dokumentieren lassen. Ziel des Projekts ist es, die Bild- und Metadatenbestände des ZI neu zu strukturieren, sie offen für Forschung und Öffentlichkeit bereitzustellen und künftig auch maschinelle Auswertungen zu ermöglichen. Perspektivisch sollen die Daten über einen Knowledge Graph zugänglich gemacht und in bestehende Fachinfrastrukturen eingebunden werden.

Ein Stockwerk höher präsentierte Henrik Schönemann (HU Berlin) im Workshop „Safeguarding und Resilienz“ die Initiative Safeguarding Research & Culture, die sich für die dezentrale Sicherung von Forschungs- und Kulturdaten einsetzt. Vor dem Hintergrund zahlreicher Kürzungen und Schließungen von Forschungszentren und -projekten durch die rechts-konservative Regierung in den USA besteht akute Gefahr des Datenverlustes. Die auf ca. 200 Personen angewachsene Community organisiert die dezentrale Archivierung der Daten mittels torrenting.1 Im Zentrum der anschließenden Diskussion ging es zum einen darum, was man konkret in Bezug auf Datenrettung und Archivierung aus dem Projekt lernen kann und zum anderen um Strategien zur digitalen Langzeitarchivierung, Unterschiede zwischen Backup und Archivierung sowie Tipps, wie sich Institutionen besser gegen Datenverlust wappnen können.

Tag 3: Datenmodelle und KI-Strategien: Sammlungen fit für die Zukunft

Im „WissKI Basis Jam“ zeigte Robert Nasarek (SODa) ein von ihm in Zusammenarbeit mit Martin Stricker entwickeltes Basismodell für die Erschließung in WissKI im Semantic Coworking Space von SODa . Ziel ist ein einfaches, anschlussfähiges Modell, das durch optionale Module wie Provenienz, Recht oder Konservierung ergänzt werden kann. Der Entwurf orientiert sich am Minimaldatensatz und wurde gemeinsam Feld für Feld diskutiert. Dabei zeigte sich schnell: Sich auf das Wesentliche zu beschränken ist oft schwer – etwa bei der Frage, wie historische und aktuelle Bildtitel sinnvoll erfasst werden können.

Parallel dazu diskutierten die Teilnehmer*innen mit Katharina Leyrer und Mathias Zinnen, wie Sammlungsdaten für den Einsatz von Künstlicher Intelligenz aufbereitet werden können. Anhand konkreter Beispiele – von der Bildklassifikation historischer Dias bis zur Strukturierung handschriftlicher Inventarzettel – wurden Chancen und Herausforderungen sichtbar.

Besonders intensiv ging es um ethische Fragen: Wie umgehen mit sensiblen Daten, beispielsweise zu menschlichen Überresten oder aus kolonialen Kontexten? Wie Bias in Kulturdatensätzen erkennen und vermeiden? Angeregt wurde zudem, ob SODa im Falle einer Verstetigung künftig Open-Source-Tools langfristig hosten könne, um Forschungsprojekte nachhaltig zu sichern.

Nach dem Barcamp ist vor dem Barcamp

Wir danken allen Teilnehmer*innen, Impulsgeber*innen und Diskussionsfreudigen, dass sie dabei waren und die Veranstaltung mitgestaltet sowie zu einer angenehmen Atmosphäre beigetragen haben.

Ein großer Dank geht an die Programmkoordination und Udo Andraschke für die perfekte Organisation – und natürlich für das fantastische Essen! Wer eine Session verpasst hat, kann viele der Workshop-Inhalte, Diskussionsstränge und referenzierten Materialien in den Etherpads des Ablaufplans finden.

Ob Digitalisierung, Provenienzangaben oder KI: Das Barcamp hat gezeigt, wie viel kreative Energie und Fachwissen in unserer Community steckt. Auch dieses Jahr gilt wieder: Nach dem Barcamp ist vor dem Barcamp, wir freuen uns schon jetzt auf das #SODaBarcamp26

- 1

Beim Torrenting werden Daten dezentral verteilt, indem Nutzer*innen Dateien untereinander in kleinen Teilen austauschen, statt sie von einem einzelnen Server herunterzuladen.