Interview von Katharina Leyrer und Anna Gnyp mit Mathias Zinnen

Machine Learning (ML) gilt als Schlüsseltechnologie und birgt enorme Chancen für die Wissenschaft. ML-Projekte sind meist interdisziplinär und kombinieren wissenschaftliches Rechnen und maschinelles Lernen, um domänenspezifische Fragestellungen zu beantworten oder datengetriebene neue Perspektiven auf Forschungsthemen zu ermöglichen.

Der Einsatz von ML im Sammlungskontext birgt in verschiedenen Phasen des Datenlebenszyklus großes Potenzial, z. B. kann durch KI-gestützte Bilderkennungs-Tools die Metadatenanreicherung bei der Erschließung effizient unterstützt werden. Auch bei der Aufbereitung für Datenanalysen von Texten und Metadaten sind ML-Tools nützlich.

Aber wie genau lässt sich ML für die Sammlungsdigitalisierung und die Forschung mit Sammlungsdaten nutzen? Welche Voraussetzung sind dafür hinsichtlich der Datenqualität und Datenkompetenzen nötig?

Darüber sprechen wir heute mit der SODa-Fachexpertise 2D und Machine Learning Mathias Zinnen (Abb. 1).

Damit Sammlungsdaten für ML nutzbar gemacht werden können, müssen sie zunächst digital vorliegen – d.h., die Objekte müssen in einem ersten Schritt digitalisiert werden. Vor welchen Herausforderungen stehen Sammlungen bei der 2D-Digitalisierung, z.B. von Bildern oder Karteikarten?

MZ: In meinen bisherigen Gesprächen mit Sammlungsverantwortlichen sind mir einige Punkte aufgefallen, die häufiger auftreten: Oft ist es zum Zeitpunkt der Digitalisierung unklar, welchen zukünftigen Anforderungen die Digitalisate genügen müssen. Einerseits geht es dabei um technische Anforderungen wie etwa die Bildauflösung, andererseits um das Ausmaß an inhaltlicher Anreicherung durch Umfang und Schema der Metadaten.

Eine weitere Herausforderung ist die Frage der persistenten Speicherung: Oft werden Digitalisierungsvorhaben im Kontext von befristeter Projektförderung durchgeführt. Die digitalisierten Objekte, und besonders deren Verfügbarmachung als Linked Open Data benötigen aber dauerhafte Pflege von Servern und Infrastruktur.

Außerdem besteht oft ein Mangel an personellen Kapazitäten, um umfangreiche Sammlungen manuell zu digitalisieren. Der Arbeitsaufwand ließe sich reduzieren, indem man die Digitalisierung zumindest teilweise automatisiert. Aber auch dafür sind natürlich Personal mit den notwendigen Datenkompetenzen sowie Hardware notwendig.

Alles klar. Wenn wir in einem ersten Schritt unsere 2D-Objekte gescannt, also digitalisiert haben, können wir ML-Anwendungen nutzen, um sie zu analysieren und anzureichern. Welche Möglichkeiten und Vorteile bieten uns ML-Anwendungen hier?

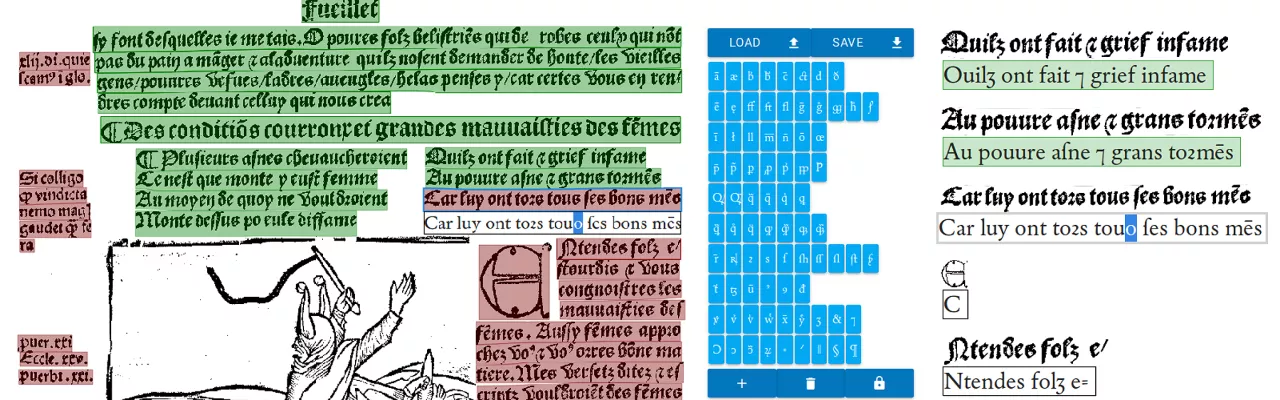

MZ: Der vielleicht offensichtlichste Vorteil besteht darin, dass die arbeitsintensive manuelle Dateneingabe, z.B. bei der Sammlungserschließung, erleichtert werden kann. Am naheliegendsten ist dabei die Digitalisierung von textuellen Daten durch Optical Character Recognition (OCR) oder Handwritten Text Recognition (HTR). Doch auch darüber hinaus bestehen Möglichkeiten, die Erfassung zu erleichtern. Analoge Metadaten, realisiert auf Inventarbüchern oder -karten, können etwa automatisiert in strukturierte Daten überführt werden. Durch Natural Language Processing (NLP) wiederum können bereits digitalisierte Texte inhaltlich verknüpft und strukturiert werden, indem Orte oder Personennamen durch Named Entity Recognition (NER) automatisch erkannt und mit Normdaten verknüft werden.

Auch Bilderkennungsalgorithmen können bei der 2D-Digitalisierung helfen. So können Bildklassifikationsalgorithmen beispielsweise teilautomatisiert Vorschläge für die Verschlagwortung von Objektabbildungen liefern, die dann manuell nur noch überprüft werden müssen.

Davon abgesehen ist uns bei SODa aber auch die Forschung mit Sammlungsdaten wichtig. Gerade Universitätssammlungen bieten dafür ein enormes Potential. Methoden des maschinellen Lernens können dabei helfen, Digitalisate verschiedener Sammlungen zu verknüpfen und Daten zu aggregieren, um Muster in großen Datenbeständen zu erkennen.

Machine Learning bietet also verschiedene Möglichkeiten für die Erschließung und Erforschung von Sammlungsdaten. Ebenso so vielfältig sind die methodischen Ansätze, die du erwähnt hast. Hast du einen Tipp, wie wir am besten anfangen können, uns dem Themenfeld Machine Learning zu nähern? Welche Kenntnisse sind dafür erforderlich?

MZ: Das hängt vermutlich davon ab, welche Ziele konkret verfolgt werden. Wenn es darum geht, welchen Anforderungen die Digitalisierung der eigenen Sammlung genügen muss, ist es hilfreich, sich einen Überblick darüber zu verschaffen, wie die Daten später in der Forschung genutzt werden können. Dafür ist es hilfreich, zumindest in Grundzügen, verschiedene Algorithmen des maschinellen Lernens zur Verarbeitung von Text, strukturierten Daten und Bilddaten zu verstehen. Dadurch kann man grob abschätzen, welche Eigenschaften der Digitalisate und deren Metadaten wichtig für die Anwendung dieser Algorithmen sind.

Andererseits kann Machine Learning wie erwähnt auch für die Digitalisierung selbst verwendet werden. Das ist ein viel konkreterer Anwendungsfall und dementsprechend kann der Fokus dann auch eher auf einem Überblick über bestehende Methoden liegen, ohne dass diese im Detail verstanden werden müssen – wobei ein Grundverständnis natürlich immer hilfreich ist.

Dabei macht es zunächst Sinn, sich die Beschaffenheit der eigenen Daten anzuschauen. Sind diese textuell, visuell, oder tabellarisch, bestehen bereits Scans oder Fotografien und ein Grundstock an Metadaten? Abhängig von der Beantwortung dieser Fragen kann man dann schauen, welche Open Source Methoden oder kommerziellen Angebote es gibt und welche sich am besten für den eigenen Anwendungszweck eignen.

Wie möchtest Du Machine Learning-Kompetenzen im Rahmen von SODa vermitteln?

MZ: Wir versuchen, möglichst viele verschiedene Formate anzubieten, um den Bedürfnissen der Sammlungslandschaft gerecht zu werden.

Zunächst gibt es bei uns das Angebot zur persönlichen Beratung über den SODa Helpdesk. Sammlungsverantwortliche oder Forschende, die mit Sammlungsdaten forschen möchten, können sich in diesem Rahmen an uns wenden. In Eins-zu-eins-Gesprächen, via Mail oder je nach Standort auch persönlich, versuchen wir die Anfragenden dann dabei zu unterstützen, die passenden Methoden für ihr Problem zu finden und anzuwenden. Diese persönlichen Beratungssituationen machen mir persönlich sogar am meisten Spaß, weil dabei spannende Daten und Projekte zum Vorschein kommen.

Persönliche Beratung lässt sich natürlich nur bis zu einem gewissen Grad skalieren und die dabei vermittelte Datenkompetenz hängt dann jeweils an einzelnen Personen. Deshalb bieten wir darüber hinaus Workshops an, die sich an eine größere Anzahl an Teilnehmenden richten und diese in erster Linie dazu befähigen sollen, bestehende Open-Source-Algorithmen selbst anwenden zu können. Darüber hinaus planen wir Workshops und eine Summer School, in denen jeweils bestimmte Felder wie OCR, Bildklassifikation oder NLP vertieft werden. In Foren möchten wir außerdem ein Grundverständnis für Machine Learning vermitteln.

Die dabei vermittelten Inhalte sollen zudem als Open Educational Resources veröffentlicht und zum Selbstlernen verwendet werden können. Außerdem möchten wir auf der SODa Homepage eine Knowledge Base und ein Glossar erstellen, in dem eine erste Übersicht über bestehende Ressourcen und Techniken vermittelt wird.

Das klingt nach tollen Angeboten! Du hast erwähnt, dass Du vor allem die Anwendung von Open-Source-Algorithmen vermitteln möchtest. Gibt es in deinem Bereich Open-Source-Software, die genutzt werden kann, und wieso präferierst Du Open Source?

MZ: Für fast alle möglichen Anwendungsbereiche von maschinellem Lernen im Sammlungskontext existiert Open-Source-Software. Wissenschaftliche Publikationen zu bestimmten Methoden des maschinellen Lernens gehen im Normalfall direkt mit der Veröffentlichung des Quellcodes einher. Der Einsatz kommerzieller Software vereinfacht häufig den Einstieg, lässt sich aber mit etwas Know-how umgehen.

Hinter Frameworks wie zum Beispiel HuggingFace, spacy, oder ultralytics YOLO, stehen zwar auch häufig finanzielle Interessen; Sie sind aber quelloffen und für nichtkommerzielle Zwecke meistens kostenfrei nutzbar. Gerade im Bereich der Texterkennung gibt es auch einige nichtkommerzielle Projekte, die aus öffentlicher Förderung entstanden sind, zum Beispiel OCR4all oder OCR-D (Abb.3).

Zudem veröffentlichen viele Forschungsprojekte ihre entwickelten Module, Bibliotheken und Frameworks auf GitHub oder anderen Repositorien. Auch diese können kostenlos nachgenutzt werden, setzen aber einen Überblick über den Forschungsstand und Projekte voraus.

Open-Source-Software verschafft Sammlungsverantwortlichen und Forschenden Autonomie bezüglich ihrer Daten und Fähigkeiten. Häufige Hindernisse stellen dabei einerseits Hardware und Systemanforderungen dar, andererseits die Kompetenz, die Software auf dem eigenen System zum Laufen zu bringen. Hier zeigt sich meiner Meinung nach das große Potential eines Datenkompetenzzentrums für die Sammlungsdigitalisierung: es kann Sammlungsverantwortlichen die Fähigkeiten vermitteln, die bestehenden Werkzeuge weitestgehend selbständig und autonom zu nutzen, ohne sich von kommerziellen Dienstleistern mit fraglicher Datenschutzethik (und neuerdings auch politischer Orientierung) abhängig zu machen. Wir möchten Sammlungsverantwortliche und alle, die mit Sammlungsdaten forschen, dazu befähigen, die Kontrolle über ihre Daten zu behalten und sich dem Zugriff der Big Tech-Unternehmen weitestgehend zu entziehen.

Momentan werden ethische Aspekte von KI-Anwendungen stark diskutiert. Spielt das im Kontext deiner Fachexpertise auch eine Rolle?

MZ: Auf jeden Fall. Einerseits im Sinne der bereits erwähnten Unabhängigkeit von Unternehmen mit kommerziellen Interessen. Daneben spielt auch der Klimaschutz eine Rolle. Durch bezahlte Schnittstellen zu Large Language Models (LLMs) wie ChatGPT oder Claude können viele sammlungs- und forschungsbezogene Probleme scheinbar unkompliziert gelöst werden. Ein Aspekt, der dabei allerdings häufig in Vergessenheit gerät, ist der damit verbundene Energieverbrauch. Beispielsweise lassen sich gedruckte Texte auf Scans zwar sehr einfach durch ChatGPT erkennen und maschinenlesbar machen, häufig reichen aber auch viel einfachere Modelle aus und liefern gleichzeitig bessere Ergebnisse. Bei SODa möchten wir dazu motivieren, überall, wo es möglich ist, einfache und weniger ressourcenhungrige Methoden zu verwenden um unnötige CO2 Emissionen zu vermeiden und Daten nicht in die Hände einiger weniger zu legen.

Vielen Dank, Mathias! Wir sind sehr gespannt auf deine Vermittlungsangebote und wünschen dir viel Erfolg bei der Verbreitung von ML-Kenntnissen und ressourcenschonender Methoden!